Ryzen AI Max 385, 14" WQXGA+ OLED MT, RAM 32GB, SSD 512GB, Srebrny, Windows 11 Pro, 3 lata OS

- Nowy

ITnes.pl sp. z o.o. jest oficjalnym partnerem HP Polska.

ITnes.pl sp. z o.o. jest oficjalnym partnerem HP Polska. ITnes.pl sp. z o.o. jest oficjalnym partnerem Lenovo Polska.

ITnes.pl sp. z o.o. jest oficjalnym partnerem Lenovo Polska. ITnes.pl sp. z o.o. jest oficjalnym partnerem ASUS Polska.

ITnes.pl sp. z o.o. jest oficjalnym partnerem ASUS Polska. ITnes.pl sp. z o.o. jest oficjalnym partnerem Microsoft Polska.

ITnes.pl sp. z o.o. jest oficjalnym partnerem Microsoft Polska.

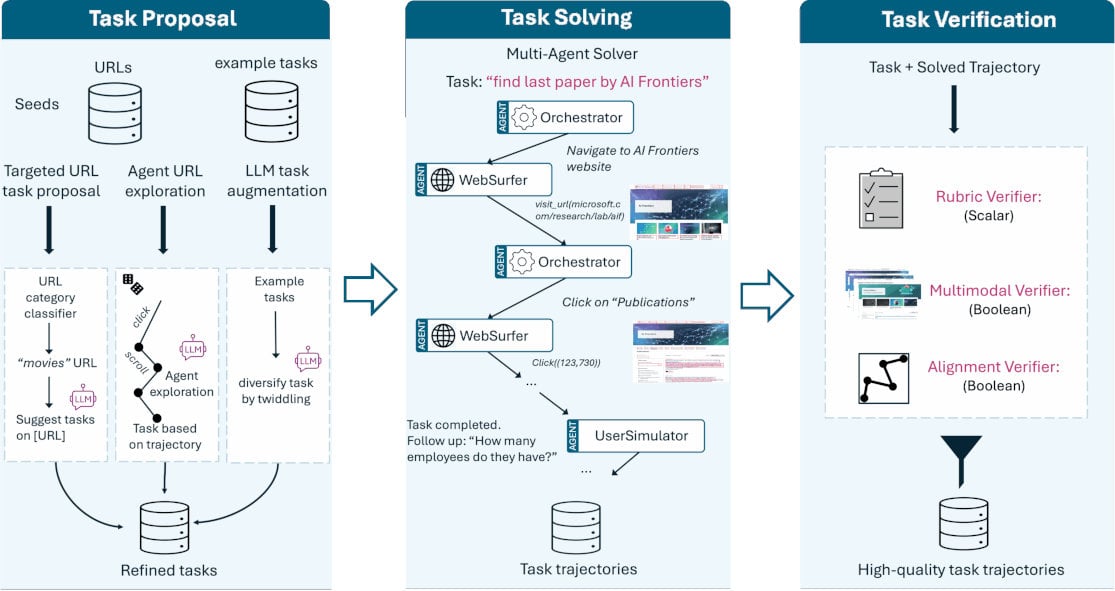

Na rynku pojawia się coraz więcej laptopów i komputerów Copilot+ PC, które potrafią uruchamiać lokalnie modele AI. Jednak aplikacji z AI działających na komputerze lokalnie jest obecnie jak na lekarstwo. Microsoft właśnie przedstawił model AI, który będzie mógł czerpać korzyści z laptopów Copilot+ PC i zautomatyzować wiele codziennych czynności przed komputerem.

FARA-7B to mały model językowy (SLM), który jest agentem do obsługi interfejsów komputerowych. Potrafi operować myszką i klawiaturą, i wykonywać czynności na komputerze podobnie jak człowiek. Potrafi wyszukiwać informacje, wypełniać formularze, dokonywać zakupów w sklepach internetowych czy dokonywać rezerwacji.

Źródło: microsoft.com

Na model FARA-7B składa się 7 miliardów parametrów, co stanowi niewielką ilość w porównaniu z innymi modelami językowymi. Dzięki temu zajmuje niewiele miejsca i może być używany wyłącznie lokalnie, czyli na komputerze użytkownika. Takie użycie zapewnia prywatność, brak wysyłania informacji z komputera w chmurę i niweluje opóźnienia związane z obróbką danych na zewnątrz. W obliczeniach potrzebnych do działania tego modelu AI sprawdzą się układy NPU w komputerach i laptopach Copilot+ PC.

Udostępniony testowy model FARA-7B przetestowano w benchmarku WebVoyager, podobnie jak inne, większe modele. Wyniki wyglądają bardzo obiecująco i deklasują większych konkurentów. FARA-7B osiągnęła 73,5% skuteczności, a znacznie większy GPT-4o już tylko 65,1%. Konkurencyjny lokalny model UI-TARS-1.5-7B w tym benchmarku uzyskał 66,4% skuteczności.

Microsoft właśnie przedstawił model AI, który będzie mógł czerpać korzyści z laptopów Copilot+ PC i zautomatyzować wiele codziennych czynności przed komputerem.

| WebVoyager | Online-Mind2Web | DeepShop | WebTailBench | ||

| SoM Agents | SoM Agent (GPT-4o) | 65.1 | 34.6 | 16.0 | 30.0 |

| GLM-4.1V-9B-Thinking | 66.8 | 33.9 | 32.0 | 22.4 | |

| Computer Use Models |

OpenAI computer-use-preview | 70.9 | 42.9 | 24.7 | 25.7 |

| UI-TARS-1.5-7B | 66.4 | 31.3 | 11.6 | 19.5 | |

| Fara-7B | 73.5 | 34.1 | 26.2 | 38.4 | |

Testy pokazują także, że FARA-7B średnio na zadanie potrzebuje 16 kroków, a wspomniany konkurent UI-TARS-1.5-7B aż 41 kroków. W benchmarku WebTailBench, który składa się z realnych zadań, takich jak porównywanie cen czy rezerwowanie biletów, FARA-7B uzyskała najlepszy wynik 38,4% skuteczności, gdzie drugi najlepszy wynik 30% uzyskał GPT-4o, a reszta konkurentów poniżej 30%.

Na tym etapie FARA-7B pokazuje duży potencjał i w wielu benchmarkach wypada lepiej niż duże modele językowe przetwarzane na zewnętrznych serwerach o dużej mocy obliczeniowej. Firma Microsoft udostępniła wersję tego modelu do testów i zaleca wykorzystywanie go w piaskownicy z pełnym nadzorem. Rozwój takich aplikacji pokazuje, że małe modele SLM przetwarzane lokalnie także mają swoją przyszłość. Będą mogły m.in. służyć do automatyzacji i wykonywania monotonnych zadań wykonywanych codziennie na komputerze, które nie będą musiały być przetwarzane na zewnętrznych serwerach tylko lokalnie przy użyciu wbudowanego układu NPU.

Nowe procesory ARM od Apple, Qualcomma i MediaTeka

Nowe procesory ARM od Apple, Qualcomma i MediaTeka

Profesjonalne karty graficzne Intela wprowadzone na rynek

Profesjonalne karty graficzne Intela wprowadzone na rynek

Trwają prace nad standardem Wi-Fi 8

Trwają prace nad standardem Wi-Fi 8

Pamięci CUDIMM i CSODIMM w komputerach i laptopach biznesowych

Pamięci CUDIMM i CSODIMM w komputerach i laptopach biznesowych

Nowe opcje przedłużenia wsparcia Windows 10

Nowe opcje przedłużenia wsparcia Windows 10

Certyfikat HP PS Lifecycle Services dla ITNES.pl

Certyfikat HP PS Lifecycle Services dla ITNES.pl

Intel, Qualcomm i Micron obawiają się ceł na półprzewodniki

Intel, Qualcomm i Micron obawiają się ceł na półprzewodniki

Nowe procesory AMD Threadripper 9000 dla HEDT i stacji roboczych

Nowe procesory AMD Threadripper 9000 dla HEDT i stacji roboczych

Dodatkowe wsparcie dla Microsoft 365 na Windows 10 do 2028 roku

Dodatkowe wsparcie dla Microsoft 365 na Windows 10 do 2028 roku

Nowe monitory iiyama do domu i biura

Nowe monitory iiyama do domu i biura

Dyski HDD 24 TB Toshiba N300 i N300 Pro dla serwerów NAS

Dyski HDD 24 TB Toshiba N300 i N300 Pro dla serwerów NAS

Microsoft Copilot+ PC również z procesorami AMD Ryzen AI 300 i Intel Core Ultra 200V

Microsoft Copilot+ PC również z procesorami AMD Ryzen AI 300 i Intel Core Ultra 200V